En la genial Un cadáver a los postres (Murder by Death) de Neil Simon, esa surrealista parodia del género de detectives dirigida por Robert Moore en 1976 –sí, la de Benson Señora–, hay un momento en el que Dick Charleston (David Niven) explica la muerte del anfitrión de la velada, el millonario Lionel Twain (Truman Capote en su única aparición en el cine), proponiendo que en realidad fue un suicidio: Twain inventó una máquina para que le apuñalara 11 o 12 veces por la espalda. A lo que su colega Sidney Wang (Peter Sellers), con su torpe manejo del idioma, replica:

— Un momento, por favor. Muy interesante teoría, señor Charleston, pero olvidado punto muy importante.

— ¿Cuál es? –indaga Charleston.

— Estúpida. Teoría más estúpida jamás oída.

Sidney Wang (Peter Sellers) en ‘Un cadáver a los postres’ (1976). Imagen de Columbia Pictures.

Hay ocasiones en que ciertos estudios científicos me devuelven a la mente aquel pasaje de la película. Se trata de los estudios que establecen una correlación entre una condición y una observación, pero donde no solamente no se demuestra ningún vínculo de causa y efecto entre ambas, sino que además la posible existencia de ese vínculo resulta algo contrario al sentido común y a cualquier atisbo de plausibilidad. Como que alguien fabrique una máquina destinada a apuñalarle 11 o 12 veces por la espalda para que parezca un homicidio. No es que sea imposible; es que se trata de una hipótesis tan descabellada que necesita más pruebas para cruzar el umbral de la credibilidad que otra mucho más plausible. Como decía Carl Sagan, y otros antes que él, afirmaciones extraordinarias requieren pruebas extraordinarias.

Imagino que quienes menos sentido encontrarán a estos estudios son los físicos. Para un físico, la naturaleza debe describirse mediante ecuaciones, incluso cuando hay incertidumbres (como en la cuántica). Pero no es necesario tirar dos veces una manzana al aire para comprobar si continúa cayendo: las ecuaciones describen perfectamente lo que hará la manzana.

La biología, mi campo, introduce sistemas más sucios (desde el punto de vista de las variables) que en la mayoría de los casos no pueden reducirse a matemática. En algunos sí se hacen aproximaciones válidas; por ejemplo, el impulso nervioso en las neuronas se describió aplicando las mismas ecuaciones que explican el comportamiento de la electricidad en los circuitos de cables.

Pero la biología es inmensamente diversa y abarca un espectro muy amplio de certidumbres, desde los modelos en los que bastan unas pocas repeticiones del experimento para tener la seguridad de que el resultado es legítimo, hasta aquellos en los que es necesario recurrir a meta-análisis, o estudios que reúnen múltiples estudios, porque ni siquiera un estudio completo es suficiente para asegurar que existe un efecto. Y a medida que nos desplazamos hacia la banda de ciencias aún más blandas, como la psicología, la necesidad de los metaestudios es aún mayor.

Lo que ocurre con los metaestudios es que el umbral de la credibilidad no es una propiedad de la naturaleza en sí, sino algo que definimos los humanos de forma más o menos arbitraria en función de algún parámetro estadístico. Me explico con un ejemplo: todos sabemos que el tabaco causa cáncer de pulmón. Pero ¿qué significa exactamente esto?

Dado que el humo se inhala, la relación entre el tabaco y el cáncer de pulmón parece plausible, lo que justifica su investigación. Tan plausible parecía la relación que ya se sospechaba a comienzos del siglo XX, cuando solo se habían descrito un centenar largo de casos de cáncer de pulmón en las revistas médicas. Los primeros estudios epidemiológicos se hicieron en Alemania en los años 20 y 30, lo que motivó la primera campaña antitabaco de la historia, la del régimen nazi. Desde entonces, decenas de miles de estudios de correlación y sus correspondientes metaestudios han apoyado este vínculo. Pero además, la relación de causa y efecto también ha sido validada por ensayos experimentales en los que se han explicado los mecanismos biológicos por los cuales ciertos compuestos del humo del tabaco provocan cambios en las células que conducen al cáncer.

Pues bien, incluso en un caso tan claro como este, y teniendo en cuenta que las cifras varían debido a la implicación de muchas variables (como el historial del paciente, su perfil genético, la edad de inicio del consumo de tabaco, la frecuencia, etc.), el cáncer afecta a alrededor de un 20% de las personas que fuman. Es decir, que la gran mayoría de las personas que fuman no sufren cáncer de pulmón.

Vayamos ahora al extremo contrario. Hace tres años, los medios montaron todo un circo con la afirmación de que el consumo de carne, sobre todo procesada, provoca cáncer. Como ya me ocupé detalladamente de intentar explicar muy claro para quien quisiera leerlo (aquí y aquí), así dicho, esto es sencillamente una barbaridad; si bien vino propiciada por una nota de prensa muy poco afortunada de la Organización Mundial de la Salud (OMS), la misma OMS que a continuación se quejaba de que los medios se habían quedado «solo con el titular».

Imagen de Pixabay.

Pero es que solo en la letra pequeña de la nota de prensa –y los medios no se caracterizan precisamente por fijarse en la letra pequeña– uno de los expertos de la OMS responsables del anuncio aclaraba que «para un individuo, el riesgo de desarrollar cáncer colorrectal por su consumo de carne procesada sigue siendo pequeño». La conclusión, el verdadero mensaje, era que el consumo de carne aumenta el riesgo de cáncer colorrectal sobre un nivel de base que es diminuto, de modo que el nivel de riesgo resultante de este aumento continúa siendo diminuto.

Pongámoslo en números para que se entienda mejor; números que publicaron varias entidades de lucha contra el cáncer y que transmitían un mensaje infinitamente más claro que la inmensamente torpe nota de prensa de la OMS: según la Sociedad contra el Cáncer de EEUU, el riesgo de una persona cualquiera de sufrir cáncer de colon es del 5%; si come carne, el riesgo aumenta a menos del 6%. Por su parte, la Unión Internacional de Control del Cáncer comparó las cifras con las del tabaco: fumar multiplica el riesgo de cáncer por 20, o lo aumenta en un 1.900%; comer carne multiplica el riesgo de cáncer por 1,18, o lo aumenta en un 18%. Creo que estas cifras dan una idea bastante clara de la magnitud del problemón que supone comer carne.

Resumiendo, para demostrar que X produce Y hacen falta dos cosas:

1. Una correlación estadística suficientemente significativa.

Insisto, el límite de lo que es significativo y lo que no lo definimos los humanos de forma arbitraria. Suelen utilizarse parámetros como el llamado valor p, del que ya he hablado aquí varias veces (como aquí y aquí). El valor p nos da una perfecta medición de cuál es el estatus probabilístico de que esa correlación signifique algo real, pero en qué punto de corte nos creemos que es real no es más que un convencionalismo; de hecho, este punto de corte es un intenso motivo de discusión entre los científicos.

También es importante aclarar que los parámetros como el valor p, o lo que consideramos estadísticamente significativo, no tienen nada que ver con el tamaño del efecto. El tabaco y la carne sirven de ejemplo: el primero tiene un efecto muy grande, mientras que el de la segunda es diminuto, y sin embargo ambos pueden tener la misma significación estadística. Basarse en esto último para decir que el riesgo de cáncer es el mismo en los dos casos es no haber entendido nada de nada.

2. Un mecanismo plausible que sea comprobable por otras vías.

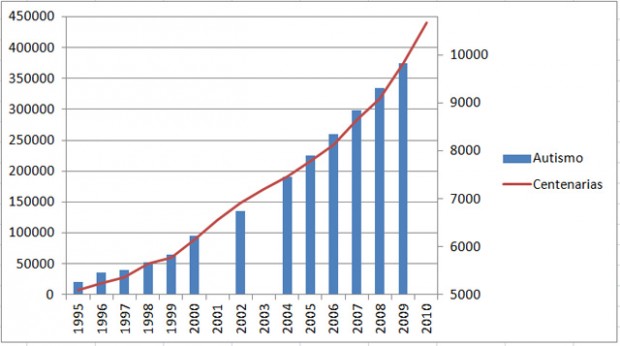

Sin un mecanismo plausible de causa y efecto, una correlación no deja de ser una casualidad curiosa, como que choquen dos coches con matrículas consecutivas. O, como decía Wang, una «teoría estúpida», como que los coches con matrículas parecidas tiendan a atraerse. Establecer correlaciones es muy fácil, teniendo una serie de datos en distintas condiciones experimentales y un software básico. Yo mismo presenté aquí correlaciones entre la evolución del número de casos de trastornos autistas y el del número de ancianas centenarias británicas, o las importaciones de petróleo en China, o la facturación de la industria turística.

Número de casos de autismo (en azul) frente a número de mujeres centenarias en Reino Unido (en rojo), de 1995 a 2010. Gráfico de elaboración propia.

Para convertir una casualidad en causalidad es preciso proponer un mecanismo plausible que pueda estudiarse por otros métodos. En el caso de la biología, se trata de llevar esa hipótesis al laboratorio; por ejemplo, ensayar in vitro e in vivo el efecto cancerígeno de los compuestos del tabaco. Pero cuando se aventura que los huracanes causan más muertes si se les pone nombre de mujer, como afirmaba un estudio hace unos años, los investigadores tendrán que buscar la manera de proponer un mecanismo y testarlo; uno que no requiera la premisa de que la población es rematadamente imbécil de solemnidad, como cuando dijeron que «la gente atribuye a los huracanes con nombre femenino ciertas cualidades asociadas a las mujeres, como la calidez, y cualidades como la agresividad a los huracanes con nombres masculinos».

Una última cosa que no debería ser necesario aclarar, pero que parece serlo, es que un mecanismo plausible no puede sustituirse por una corazonada, una intuición o el deseo muy fuerte de que algo sea cierto. Por ejemplo, cuando se publicó lo de la carne y el cáncer hubo ciertas personas del veganismo proselitista, el que pretende imponer su credo al resto de la humanidad, que ya lo sabían, y que seleccionaron los pedacitos de información más sensacionalista publicados por los medios peor informados para defender su visión.

Lo preocupante es que estos prejuicios, ideas preconcebidas y sesgos cognitivos no solo afectan al público no científico, sino también a los propios investigadores cuando emprenden un estudio tratando por todos los medios de demostrar lo que previamente ya saben. En ciertos casos ocurre que los estudios nacen ya contaminados por prejuicios éticos, culturales, sociales o de otro tipo, todo eso que los investigadores deberían dejar en la puerta junto con el paraguas antes de entrar en el laboratorio. Un ejemplo que he comentado aquí varias veces son los estudios que han tratado de probar los efectos negativos que produce escuchar música heavy metal, y en el que han llegado a darse casos de estudios que lo afirmaban incluso cuando sus datos no apoyaban tal afirmación.

Mientras no haya un mecanismo plausible, debe aplicarse el principio de Wang: «teoría estúpida». Mañana les contaré otro ejemplo muy sabroso de ello.