Un tranvía corre sin frenos hacia cinco trabajadores que, ajenos a la desgracia que les espera, arreglan unas traviesas. Si nadie lo remedia morirán arrollados. Por fortuna, alguien lo puede remediar, usted, que presencia la escena: basta con que cambie las agujas para desviar el vagón hacía una vía muerta en la que solo hay un trabajador. Es cierto que ese trabajador morirá, pero se salvarán los otros cinco. ¿Cambiaría las agujas sabiendo cuál es el resultado de su decisión?

Si considera que salvar a cinco personas es la mejor opción en este caso, coincidirá usted con la mayoría de la gente: en efecto, el 90% dice que cambiaría las agujas. Sin embargo, imagine que se encuentra ante una situación similar a la anterior, pero ahora en lugar de cambiar las agujas tiene que empujar a una persona muy gorda para que con su gran volumen detenga el tranvía. Esa persona también morirá sin remedio, pero las otras cinco se salvarán. ¿La empujaría? ¿Qué le dictan sus intuiciones morales en este caso?

Aunque de nuevo se trata de salvar a cinco personas a costa de una, en esta ocasión solo un 25% de la gente asegura que daría el empujón fatal: no es lo mismo matar que dejar morir; eso es lo que, al parecer, nos dicen nuestras intuiciones morales. ¿Y si el que está en la vía muerta es su padre? ¿Y si es su hijo? ¿Los sacrificaría para salvar a cinco personas? La intuición nos dicta que no tenemos por qué cambiar las agujas. ¿Y si es un niño desconocido? En tal caso, las intuiciones morales de hombres y mujeres son distintas, pues ellos dicen estar dispuestos en mayor medida que ellas a desviar el tranvía.

Las intuiciones morales –la percepción inmediata de que una acción es moralmente correcta o incorrecta– son importantes para entender muchas de nuestras decisiones, convicciones, dilemas y contradicciones. Esas intuiciones a veces son claras y la reflexión las confirma; otras, sin embargo, son confusas, poco fiables y están sesgadas por todo tipo de prejuicios. En cualquier caso, es preciso conocerlas bien, tanto su naturaleza como sus fundamentos, dado que nos sirven de guía para la acción moral. Esa es, precisamente, la tarea de una nueva rama de la filosofía denominada ‘ética experimental’. Ahora bien, ¿‘ética’ y ‘experimental’ no son términos contrapuestos? ¿Cómo puede ser experimental una disciplina que trata sobre el deber ser, sobre cómo debemos comportarnos?

La filosofía se ha considerado ajena a la producción de datos, lo que no significa que haya carecido de interés por ellos y por las ciencias que los generan. De hecho, durante los siglos XIX y XX (cuando la separación entre ciencia y filosofía ya es completa) buena parte de la mejor filosofía se apoyó en datos científicos de todo tipo, sociales y naturales, para reforzar o ilustrar sus teorías. Sin embargo, no era su misión producirlos; antes al contrario, cómodamente sentado en su butacón, el filósofo especulaba sobre los fundamentos de la realidad natural, social o política y sobre la naturaleza de la moral sin mancharse las manos con cuestiones empíricas. Con el surgimiento de la ética experimental, apenas hace diez años, ese panorama cambió por completo: como otras ramas de la filosofía, la ética se ha propuesto ahora generar sus propios datos.

¿Pero qué necesidad tiene la ética de producir datos? ¿Qué busca? Busca intuiciones morales como las del ejemplo del tranvía u otras similares sobre egoísmo, altruismo, virtud, tolerancia, honradez, corrupción, crueldad, generosidad, etc. ¿Devolvería usted una cartera llena de dinero? ¿Llegaría tarde a una importante cita por ayudar a alguien? ¿Renunciaría a un soborno millonario? La ética experimental estudia las intuiciones morales de la gente para conocer su naturaleza y sus límites, propiciando al mismo tiempo que las teorías éticas sean más realistas. Supongamos que ningún ser humano estuviera dispuesto a mover las agujas del tranvía para salvar a cinco personas frente a una, ¿qué sentido tendría que una teoría nos dijera que el cambio de agujas es lo correcto? Parafraseando a Kant, podemos afirmar entonces que las teorías éticas sin intuiciones son ciegas, pues resultan ajenas a la psicología moral humana (teorías para dioses o demonios); pero las intuiciones morales sin teorías son vacías, pues nos guían de forma contradictoria en demasiadas ocasiones.

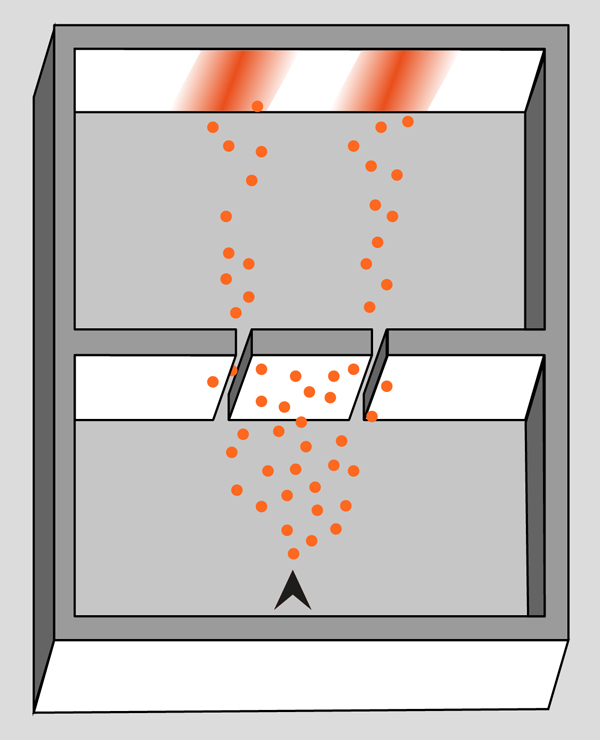

Así pues, lejos del confortable butacón, filósofos y filósofas llevan a cabo experimentos hipotéticos o reales similares a los de la psicología o la economía. En los primeros, los participantes deben expresar un juicio moral sobre una situación hipotética dada (el problema del tranvía, por ejemplo); en los reales, tienen que tomar una decisión moral, ya sea de forma individual o como producto de la cooperación. Imagínese, por ejemplo, que en el laboratorio de ética le entregan 20 monedas de un euro y tiene que decidir si darle a otra persona, elegida al azar, una moneda, o dos, o tres, o cuatro, o cinco… o todas, o bien puede no darle ninguna; esto es, se queda usted con los 20 euros. A su vez, la persona en cuestión tiene en su mano aceptar la oferta –por ejemplo, usted le ofrece 4 euros– o rechazarla. Ahora bien, si la rechaza ambos se quedan sin nada. ¿Usted cuánto ofrecería? ¿Cuál es su intuición moral en este caso? ¿Cuál sería la oferta más justa?

Experimentos hipotéticos o reales ponen a las personas, pues, frente a su concepción del bien y lo correcto; y las teorías éticas se benefician de ese conocimiento. De vuelta al butacón se puede especular de nuevo sobre principios y consecuencias morales apoyándose en bases más firmes. La ética experimental consigue así elaborar teorías normativas y empíricas a la vez; logra, en otras palabras, ser filosofía y ciencia al mismo tiempo. Démosle la bienvenida.

* Fernando Aguiar es investigador del CSIC en el Instituto de Estudios Avanzados (IESA).